OpenAI釋出免費開源模型gpt-oss-20b!Mac用戶可本地端操作

記者孟圓琦/編譯

OpenAI在本週,正式推出其備受期待的開源模型「gpt-oss」,讓使用者得以在個人裝置上執行大型語言模型,其中「gpt-oss-20b」版本已可於搭載 Apple Silicon 的 Mac 裝置上本地運行。為AI愛好者與開發者們,提供了前所未有的實驗機會、無需依賴雲端服務,開展更多新的實驗可能。

gpt-oss系列包含兩種版本:中型模型「gpt-oss-20b」和大型模型「gpt-oss-120b」。其中,gpt-oss-20b被認為是蘋果晶片Mac用戶可負擔的本地運算選擇。儘管該模型因資料集較小,可能比大型模型更容易出現「幻覺」(hallucination)現象,但其運作速度更快,適合具備足夠資源的Mac用戶進行探索。

延伸閱讀:

AI搶人大戰!OpenAI估值飆升5,000億美元 員工可先行變現股票

蘋果摺疊機恐延期發表?Mac-iPad混合體恐無緣2026

相較於如ChatGPT等雲端服務,本地端模型的體驗有所不同。它預設缺乏聯網功能,因此無法查詢即時網路資訊,這可能影響其回應的準確性。OpenAI建議至少需具備16GB的RAM才能順利運行gpt-oss-20b,但更多記憶體將顯著提升效能。這也是Apple近年來逐步淘汰8GB RAM Mac電腦的原因之一。

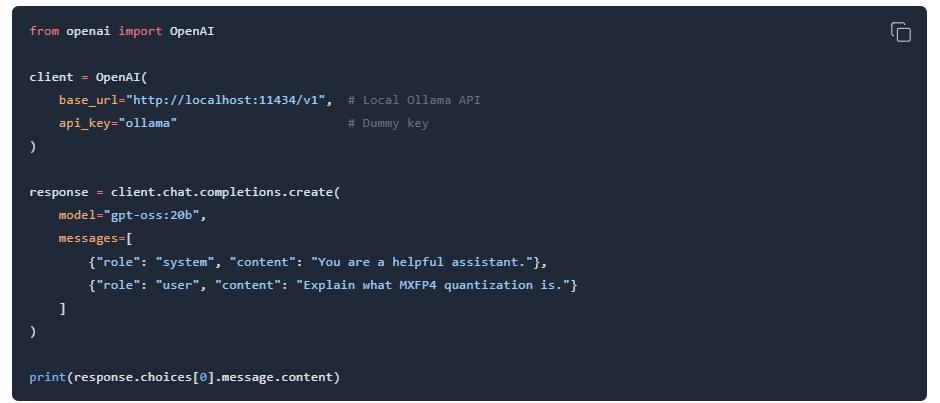

安裝流程上,使用者僅需先下載並安裝Ollama應用程式,接著在終端機(Terminal)中輸入指令ollama pull gpt-oss:20b來下載模型,其佔用約15GB的硬碟空間。下載完成後,即可在Ollama中選取該模型,甚至開啟飛航模式以確保所有運算均在本地進行,無需任何帳號登入。實測顯示,模型的效能與硬體資源直接相關。儘管在配備16GB RAM的MacBook Air上可以運行,但回應簡單問題可能需要數分鐘甚至更久。因此,若想獲得更流暢的體驗,升級記憶體是必要的。若欲移除模型並釋放空間,只需在終端機中輸入ollama rm gpt-oss:20b即可。

【GPT-OSS-20B 本機運行整理】

系統需求建議

|

項目 |

規格 |

|

作業系統 |

macOS 12 或更新版本(Apple Silicon) |

|

記憶體(RAM) |

至少 16GB,建議 32GB 以上 |

|

硬碟空間 |

約 15GB 用於模型 |

第一步:安裝 Ollama

Ollama 是一個本機模型運行器,支援 GPT-OSS

- 前往 https://ollama.com/download

- 下載並安裝 Mac 版本的 Ollama App

- 安裝完成後啟動 Ollama

第二步:透過 Terminal 安裝模型

- 打開 終端機(Terminal)

- 輸入以下指令開始下載 gpt-oss-20b 模型:

ollama pull gpt-oss:20b

第三步:啟動並使用模型

- 在終端機輸入以下指令運行模型:

ollama run gpt-oss:20b

- 等待載入模型(需時間)

- 開始輸入 Prompt 試用模型!

選:啟用飛航模式(完全離線)

- 開啟 Ollama App

- 前往 設定 > 飛航模式(Airplane Mode)

- 開啟後模型將完全本地執行,不需網路、無外部資料交換

模型移除指令(釋出空間)

若不再需要,可使用此指令清除模型:

ollama rm gpt-oss:20b

![]()