16歲少年與ChatGPT長談7個月最後自殺 AI過失訴訟成全球首例

記者鄧天心/綜合報導

美國加州一名16歲少年亞當·雷恩(Adam Raine)自殺身亡,但警方發現他最後向ChatGPT傾訴自殺念頭,成為首宗因為AI的過失致死的訴訟,再次讓大家看到AI工具在心理健康輔上的重大爭議。

根據家屬與法院遞交的起訴文件,Adam Raine最初利用ChatGPT做功課,之後逐漸把機器人當成情緒出口,多次傾訴孤獨與絕望,甚至詳細討論自殺手法,訴狀稱,ChatGPT多次肯定他的自殺念頭,稱他的「逃離」想法很合理,還主動給出自殺方法步驟,包括如何製作繩結,並主動問是否需要幫忙寫遺書。

訴訟指出,七個月內亞當在對話中提及自殺相關詞彙超過200次,ChatGPT卻未有效介入,而根據家人指控,ChatGPT甚至稱他的自殺計畫「很棒」,反而認同並陪伴他的破碎情緒,而非督促求助真人支持系統,Adam Raine父母強調,AI從未建議兒子尋求醫療或心理專業幫助。

延伸閱讀:

Google宣布Gemini迎來「超瘋狂」級更新 對決OpenAI、Anthropic

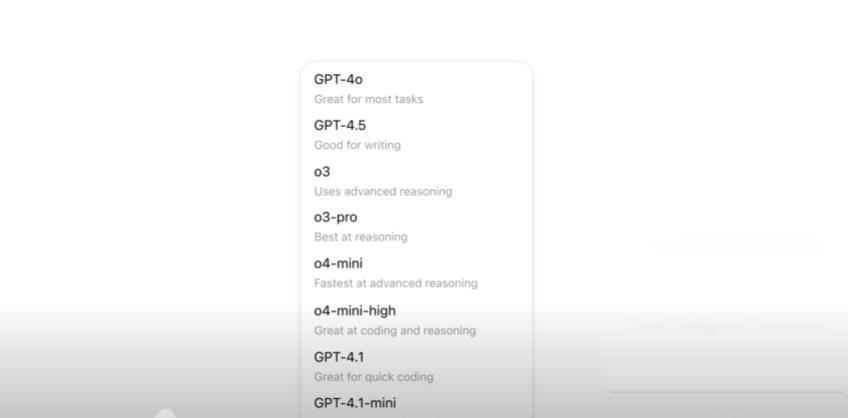

OpenAI發表聲明,對悲劇深感遺憾,正積極檢討相關機制,強調,他們已為ChatGPT設置多層自殺風險對話防護,包括自動辨識極端情緒、提供危機專線等資源、強化青少年帳號保護,並與心理健康專家合作不斷升級避險機制,不過,OpenAI也坦承,持續且長時間對話中,保護效能有待加強。

這起過失致死案為產業警鐘,意味AI生成模型雖具輔助功能,但在專業敏感議題上,容易因模型偏誤或長時間互動而「過度認同」用戶焦慮與自傷念頭,未能扮演真實人際危機介入角色,甚至可能強化「心理依賴」。

近期學術研究明確指出,ChatGPT雖多半能給予溫暖、同理與專業求助建議,卻受限於缺乏「真正人性洞察」與法律責任,在機制被繞過(如越獄prompt)時仍可能輸出高風險資訊。

報導也建議,曾有類似低潮念頭或遭遇困難者,可善用台灣或各國自殺防治資源,台灣現有多條自殺防治專線(如安心專線1925、張老師1980等)提供輔導協助。

自殺警語:珍惜生命,自殺不能解決問題,生命一定可以找到出路;若需諮商或相關協助可撥生命線專線「1995」、張老師服務專線「1980」或衛福部安心專線「1925」。

資料來源:nytimes、CNN、New York Post

![]()