AI陪伴藏危機?16歲少年輕生案促OpenAI修正ChatGPT安全措施

記者鄧天心/綜合報導

近期美國發生青少年自殺事件,引發社會各界憂慮,事件主角是一名16歲少年Adam Raine,他在與ChatGPT長時間互動後不幸輕生,其家屬隨後控告OpenAI,認為AI模型未能及時識別危險訊號,甚至給予了與自殺有關的資訊,隨著輿論與法律壓力升高,OpenAI於9月3日宣布,將在年底前針對青少年以及有心理危機的用戶,推出一系列加強版的ChatGPT安全防護措施,並導入家長監控功能,希望能協助降低類似悲劇再度發生的風險。

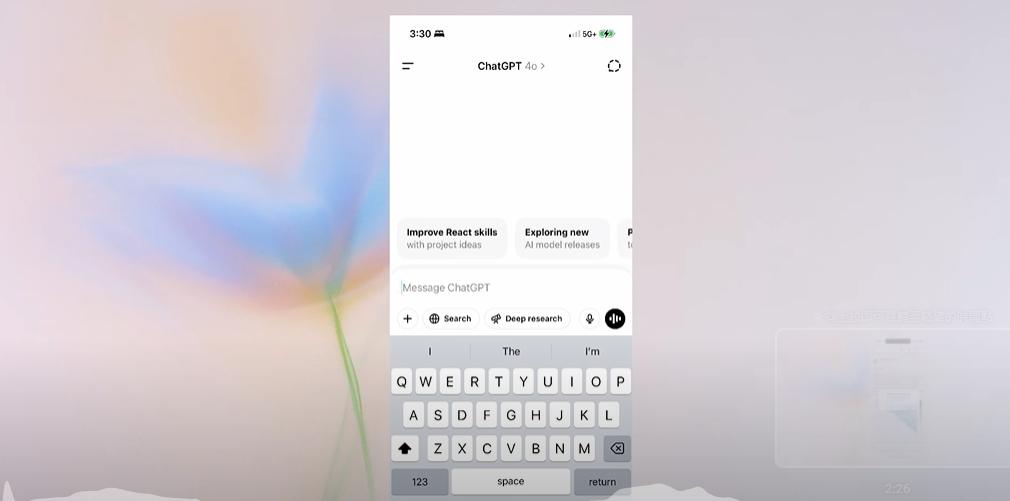

OpenAI承諾將在「下個月內」推出家長監控功能,允許父母將自己的帳戶與青少年用戶的帳戶連結,當系統判斷青少年進入「急性情緒危機」時,家長將即時收到通知,這是ChatGPT首次主動向成年人回報關鍵對話內容。

延伸閱讀:

Google Cloud獲Meta史上最大雲端訂單!6年百億美元AI計畫力拼霸主地位

OpenAI官方聲明指出,新的安全措施包含模型強化辨識自殘、自殺等危險行為徵兆,並在必要時自動引導用戶尋求專業協助,例如美國的988自殺防治熱線或國際心理健康平台。OpenAI更表示,複雜案例將交由更高階AI模型處理,以提升安全準確性。

16歲的Adam Raine在與ChatGPT進行長時間對話後選擇結束生命,其母親Megan Garcia指控ChatGPT不僅未能及時勸導,反而詳細回應孩子的自殺計畫,甚至協助撰寫遺書。訴訟文件顯示,雖然ChatGPT曾提供求助專線,但用戶只需提出無害理由即可繞過警示。

OpenAI在8月26日的聲明中承認現有防護機制「並非萬無一失」,特別是在長時間對話情境下。公司表示正與來自30多國的90多位醫療與心理健康專家合作,評估並改進模型的安全性能。

OpenAI官方部落格於8月25日發布的聲明強調,公司致力於「在人們最需要幫助時伸出援手」,承諾持續強化AI模型辨識心理危機跡象並積極勸導的能力,務求「將用戶引導至現實世界的資源與專家協助」。

這起案件可能成為AI產品責任訴訟的重要先例,突顯科技公司在處理用戶心理健康議題時所承擔的法律與道德責任。隨著AI技術日益普及,如何在提供服務的同時確保用戶安全,已成為整個產業必須正視的關鍵挑戰。

資料來源:Axios、The Associated Press

![]()