NVIDIA成關鍵推手!Speak大幅強化核心語音辨識系統

記者/孫敬 Archer Sun

AI語言學習平台Speak近日宣布整合多平台訓練數據,以此提升核心語音辨識系統,助使用者能更貼近外文使用者實際互動場景。與之前的模型相比,Speak透過NVIDA旗下產品,降低新版模型的字詞錯誤率(WER)達45%,整體字詞錯誤率亦減少超過60%,訓練數據集中在特定領域,涵蓋多種強烈口音,這些口音是現成的模型難以處理的。

延伸閱讀:AI 語言學習平台 Speak 前進台灣市場 推動在地化學習內容

NVIDIA NeMo加速Speak開發、訓練語言模型

早期Speak曾針對iOS、Android作業系統分別搭建不同的語音辨識系統,搭配Speak客製化模型及協力廠商提供多個語音辨識模型進行訓練,但其中包含Speak當初為支援大量版本、各種不同且老舊的行動裝置,使用較小型及效能不佳的訓練模型,導致數據來源分散、重複,造成系統端整合數據資料時,運維工作量倍增且複雜。

為有效解決這個問題,Speak透過NVIDIA NeMo;一款專為研究和開發語音和大語言模型所開發的端對端雲原生開源框架,來加速分散式訓練和模型的開發維運。在整合自動語音辨識(ASR) 模型推理及後處理邏輯,Speak將核心語音基礎架構重新打造為單一、更大型的後端系統,導入來自全球Speak App裡面數千小時學習者、帶有各地濃厚口音的英語語音作為訓練數據庫,將Speak所有數據庫整合,簡化維運以確保所有用戶和裝置,都能獲得即時、高效的服務回饋。

NVIDIA Riva加速用戶端雙向互動

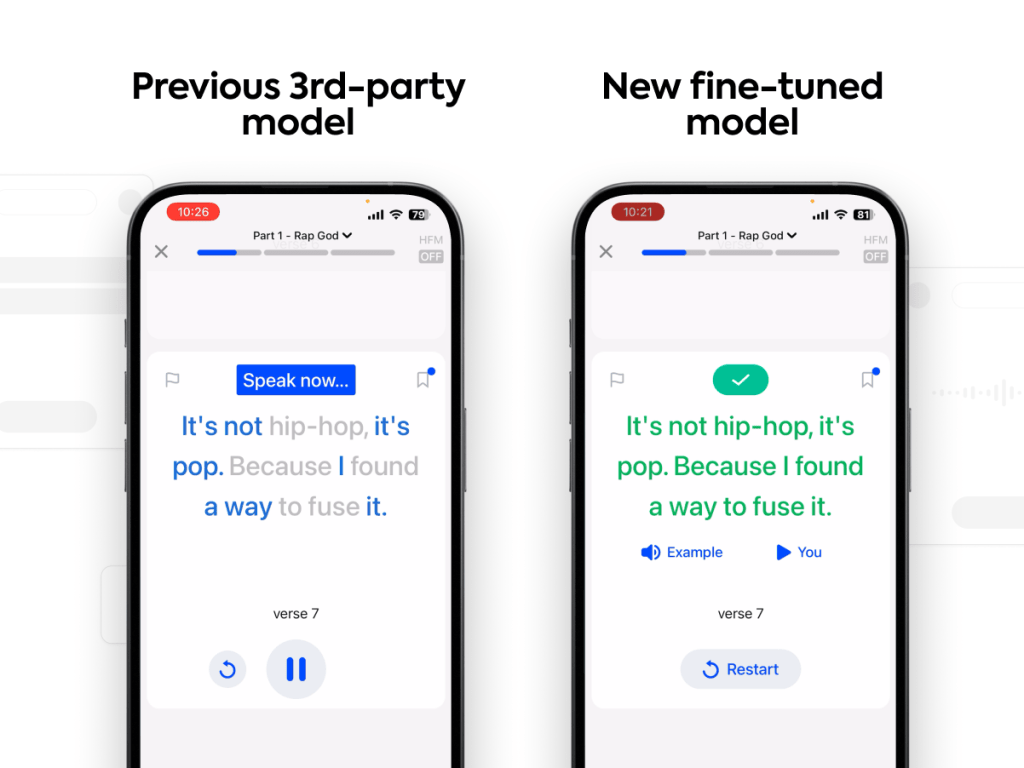

在精準辨識用戶英語口音方面,Speak使用了Conformer語音辨識模組(一種用於聲音和語音處理的深度學習模型結構,用於語音識別和自然語言處理任務),並以微調後的Conformer-CTC架構訓練全球Speak帶有濃厚口音的英語語音數據庫,以快速辨識長串語句的關聯字詞,並根據上下文語意特徵,快速給予回饋。

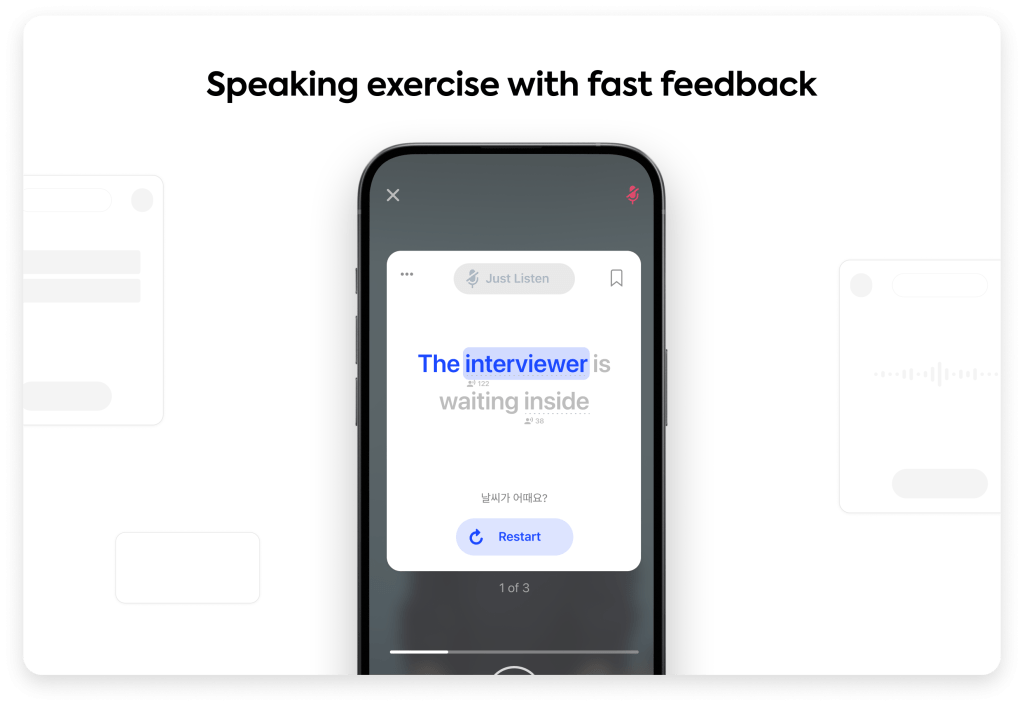

除此之外,用戶重視的即時互動體驗,Speak將微調後的Conformer-CTC 架構,部署並運行在NVIDIA Riva 上(NVIDIA Riva是一組GPU加速的多語言語音和翻譯微服務),讓聲音數據在系統和用戶端之間的傳遞更有效率、創造高速的雙向互動。

Speak表示,「過去從提示用戶開始說話並錄音的那一刻起,用戶平均需要大約1.6秒才能收到第一個口語的回饋,但使用升級的系統架構之後,相較於以前使用協力廠商的語音辨識服務,平均速度提高了20%。Speak還會根據每日流量在不同時間的高低不同來擴展Riva節點,並確保至少每260毫秒提供一次回饋,能夠達到與日常對話中人類的平均反應時間接近。」

※探索職場,透視薪資行情,請參考【科技類-職缺百科】幫助你找到最適合的舞台!

瀏覽 486 次