企業高層面對生成式AI時應有四個捫心自問|專家論點【Howie Su】

作者:Howie Su(產業分析師)

導入技術?許多管理階層還是摸不著頭緒

通常一家企業要導入新技術時的阻礙之一不是在員工,而是在管理階層的猶豫不決,特別當這些技術影響的範圍很廣時,一下子要從哪開始不只是營運問題,更可能牽涉到資源分配的政治問題,麥肯錫就指出,董事會應該負責其監管的公司如何使用生成式人工智慧,並向公司領導者提出正確的問題將有助於釋放技術的價值,同時管理其風險。雖然各種應用案例層出不窮,軟體開發人員可以使用生成式人工智慧來建立代碼、律師事務所可以從大量文件中回答複雜的問題、科學家可以創造新的蛋白質序列來加速藥物發現,但這些對董事會來說好像都太過遙遠,大家都怕成為人工智慧的落後者,但又很難抓到跟自身關係密切的關聯性,因此,麥肯錫提出四個問題,讓管理階層好好思考如何挖掘技術的價值。

問題一:生成式人工智慧在短期與長期內將如何影響我們的產業和公司?

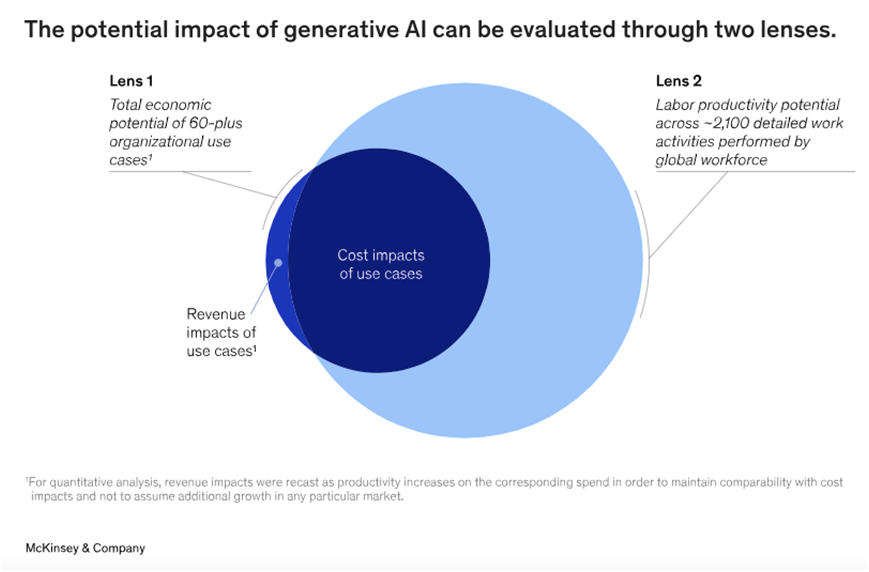

這是一個看似簡單但實際相當不好回答的問題,第一波應用將出現在軟體、銷售、客戶服務和產品開發領域,因此,生成式人工智慧的早期影響可能會集中在特別仰賴這些功能的產業,例如媒體和娛樂、銀行、消費品、電信、生命科學和技術服務商等。由於生成式人工智慧可以提高各人員的生產力,並全球範創造了高達 7.9 兆美元的價值,每家公司都希望立即探索提高效率和效益的機會,不這樣做的公司可能很快就會發現自己落後競爭對手,短中長期的技術帶來影響,是管理階層首先要評估的問題。

問題二:是否在價值創造與風險管理之間取得平衡?

了解當前與未來情境只是基本,技術價值與風險的權衡才是開始困難的地方。舉例而言,與傳統人工智慧一樣,生成式人工智智慧也會引起隱私問題和道德風險,例如訓練數據中隱藏的偏見可能會長期存在,它還產生更多的攻擊領域和新的攻擊形式,提高安全漏洞的存在。例如,深度偽造可以模仿公司管理階層的樣貌與聲音,並對大眾發佈虛假資訊,影響形象與股價,其他風險包含生侵犯版權、商標、專利或其他受法律保護的內容的風險。董事會需要確信公司已經為整個公司承擔的已知生成人工智能風險建立了法律和監管框架,而公司內部的人工智慧也受到持續的審查與衡量。

問題三:我們應該如何有效率地組織生成人工智慧?

公司管理階層應考慮任命一名高級管理人員來負責監督和控制所有生成式人工智慧活動,並建立一個由代表數據科學、工程、法律、資安、業務、產品設計和其他職能人員組成的跨職能小組,這樣的團隊可以協作快速、廣泛地制定與實施策略。同時,由於基礎模型可以提供企業的多個使用案例,因此董事會成員須要求在生成式人工智慧的使用上採取協調一致的方法,也需要與定制模型的提供商,或與提供可擴展雲端等功能的基礎設施維持關係。

問題四:我們到底有什麼技術能力?

現代數據和技術堆疊將是成功使用生成式人工智慧的關鍵,雖然基礎模型可以支持廣泛的用例,但許多最有影響力的模型是包含特有數據的模型,同樣重要的是設計包含數據治理的可擴展數據架構的能力和安全程式,企業也需要根據當前應用案例,現有運算資源與工具基礎設施評估升級的必要性。因此,管理團隊須明白所需的運算資源、數據系統、工具和模型,以及取得它們的策略。

此外,董事會的組成並根據實際需求進行調整,以確保擁有足夠的技術專業知識。過去,當公司很難找到具有董事會成員所需的更廣泛業務專業知識的技術專家時,一些公司透過設立包括生成人工智慧專家的技術顧問委員會來獲得支持。然而,生成式人工智慧可能會對公司運營的各個方面產生影響,例如風險、薪酬、人才、資安、財務和戰略。因此,人工智慧專業知識需要廣泛普及化,以便全體董事會及其所有委員會能夠正確考慮其影響。

瀏覽 1,118 次