4大亮點揭密蘋果AI模型訓練細節 獨有架構優化反應速度與準確率

記者孟圓琦/編譯

蘋果在 WWDC25 全球開發者大會後,近期更進一步,公開了一份名為「Apple Intelligence Foundation Language Models – Tech Report 2025」的技術報告。其中深入剖析了這些新模型在訓練、優化與評估過程中的關鍵細節,一揭《Apple Intelligence》背後「大腦」的神秘面紗。

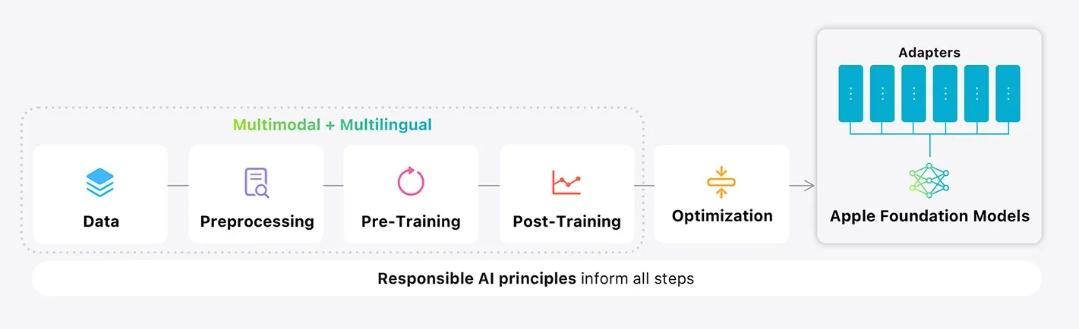

這份技術性雖高但價值非凡的報告,巨細靡遺地闡述了新模型的架構、數據來源、預訓練、後訓練、工具使用開發、性能優化及基準測試等多個層面。其中4大亮點,可一窺蘋果 AI 的尖端技術:

裝置端模型:在輕巧中實現強大性能

蘋果的裝置端模型(即供開發者使用的那款)擁有約 30 億個參數。然而,這份新報告揭示了其內部巧妙的設計:該模型被分割成兩個區塊。區塊 1 包含了總 Transformer 層的 62.5%,而區塊 2 則包含了剩餘的 37.5% Transformer 層,但值得注意的是,區塊 2 移除了關鍵和數值投影。

這項創新設計帶來了實質性的效能提升。透過這樣的分割,裝置端模型所需的緩存記憶體減少了 37.5%,同時首次輸出詞元(Token)所需的時間也縮短了約 37.5%。儘管進行了分割,蘋果強調其設計方式確保了模型的整體性能和輸出品質不受影響。

這項技術策略的背後,是蘋果長期以來在優化本地 AI 性能上的探索。幾年前,蘋果就曾研究過如何在記憶體受限的設備上,透過在 RAM 和快閃儲存之間按需交換大型語言模型(LLM)部分內容,來運行比設備記憶體容量更大的模型。雖然最終的解決方案有所不同,但這充分展現了蘋果致力於在輕量級設備上提供高性能 AI 的決心。

延伸閱讀:

傳蘋果新一代iPad Pro將配置雙前置鏡頭?結合M5晶片穰橫豎體驗都順暢

盤點iOS 26的7大革新AI功能!升級你的智慧生活

雲端模型:為「私有雲計算」量身打造的精妙架構

對於其伺服器端模型,蘋果為其「私有雲計算」(Private Cloud Compute)平台量身打造了一種獨特的自訂架構,名為「平行軌道專家混合模型」(Parallel-Track Mixture-of-Experts, PT-MoE)。

簡而言之,「專家混合模型」(MoE)是種突破性的 AI 模型設計。它不再依賴一個龐大、單一的模型來處理所有任務,而是將其分解為多個較小的子網路,或稱之為「專家」。這些「專家」只會在處理與其專長相關的任務時才被激活。舉例來說,如果您的提示與烹飪相關,那麼只有負責烹飪領域的專家會被喚醒並參與計算,而其他專家則保持休眠狀態。這種模組化設計使得整體模型雖然依然龐大,但其響應速度更快,且往往更為精準,避免了所有提示都必須通過一個龐大統一模型而導致的效率低下。

蘋果在此基礎上,進一步創新,構建了一種新型的 Transformer,命名為「平行軌道 Transformer」,並透過 MoE 層進行擴展。傳統的 Transformer 模型通常透過單一堆疊的層次逐一處理詞元。然而,蘋果的設計打破了這種單軌處理模式,將模型分解為多個平行軌道。每個軌道都能獨立處理詞元,僅在特定節點進行同步。

更為精妙的是,在每個平行軌道內部,蘋果用 MoE 層取代了部分常規 Transformer層。這意味著每個詞元只需激活少數幾個專家,而其餘專家則保持閒置。由於每個軌道都擁有其專屬的局部專家,模型有效避免了傳統設計中,所有計算必須跨越整個系統協調而造成的處理瓶頸。

此外,蘋果還加入了一種巧妙的設計,旨在平衡局部上下文理解與全局宏觀視野,稱之為「交錯全局與局部注意力層」(Interleaving Global and Local Attention Layers)。最終,這一切技術的結合,成就了一個高度模組化、高效且可擴展的 AI 模型,它不僅運行速度更快、資源消耗更少,同時也保持了卓越的智能水平。

多語言能力飛躍:全球用戶體驗的基石

《Apple Intelligence》初期發布時,對英語之外語言支援的局限性曾是其廣受批評的焦點。為此,蘋果在其新模型中大幅提升了多語言支援能力。

報告顯示,蘋果在訓練過程中將多語言數據的使用量從 8% 大幅提升至 30%。這些數據來源包括自然產生的內容和透過生成技術創造的合成內容。同時,蘋果還將其分詞器(Tokeniser)的詞彙庫容量擴大了50%,使其模型現在能夠識別15萬個不同的詞元,相較於之前的10萬個有了顯著增長。

蘋果表示,這些改進使得其模型在非英語基準測試中取得了「顯著進步」,尤其是在強化學習微調之後。值得注意的是,報告中強調,評估是透過母語使用者編寫的提示進行的(而非簡單翻譯),並同時測試了模型在當地語境中的準確性和回應的自然度。這意味著未來像「寫作工具」(Writing Tools)這樣的功能,在其他受支援語言中的表現將會更加可靠和地道。

數據來源解析:多元化、高質量與隱私保護

一如其首批模型,蘋果新模型的訓練數據主要來自網絡爬取。但蘋果明確指出,其 Applebot 爬蟲會嚴格遵守 robots.txt 排除規則,這表示如果網站經營者不希望蘋果抓取其內容,可以透過設定告知,Applebot 便會停止抓取。

以下是蘋果新模型數據來源的詳細構成:

-

公開可用網絡數據:

儘管蘋果未具體量化比例,但確認其訓練數據的最大部分來自 Applebot 爬取的網頁內容。為了確保數據品質,蘋果應用了多層過濾機制,篩除低品質、不安全或不相關的內容,包括垃圾郵件頁面、淺薄或模板化的文本以及格式錯誤的內容。

-

授權數據:

蘋果在報告中僅簡要提及部分訓練數據是從出版商處獲得授權。早前業界報導曾指出,蘋果正與 Condé Nast(旗下擁有《紐約客》、《時尚》、《連線》等)、NBC 新聞以及 IAC(旗下擁有《人物》、《每日野獸》和《美好家園與花園》等)進行內容授權談判,因此這些資料很可能已納入其訓練集。

-

合成數據:

蘋果透過較小型模型和自訂管線來生成合成數據,這類數據尤其用於數學、程式碼、指令微調以及視覺語言任務。雖然報告未明確合成數據在總數據集中的佔比,但強調其在微調、強化學習和提升多語言支援等關鍵訓練步驟中扮演了重要角色。

值得澄清的是,合成數據並非「憑空捏造」或「虛構內容」,而是透過演算法從現有數據中學習並生成具備特定屬性、結構的全新數據,對於彌補數據不足、增強模型穩健性至關重要。 -

視覺數據:

為了提升圖像理解能力,蘋果收集了超過 100 億對圖像-標題組合,其中包括透過光學字符識別(OCR)從螢幕截圖中提取的文字,以及手寫筆記。

此外,蘋果還利用自身的模型生成了額外且更為豐富的圖像標題。過去有報導稱蘋果曾與 Shutterstock 進行圖像內容授權談判,因此部分授權圖像素材也可能已用於此目的

資料來源:9to5mac

![]()