芝加哥大學打造Glaze機制 防堵AI模仿藝術品

記者/竹二

自從生成式AI出現後,引發許多疑慮,像是無法分辨真假、資料來源不可靠,以及是否有侵權問題。近日美國芝加哥大學就釋出了Glaze Beta2,藝術家只要在上傳作品到網路上之前,利用Glaze將作品稍加變更,就能避免AI模型剽竊概念與風格,進而生成類似的作品。

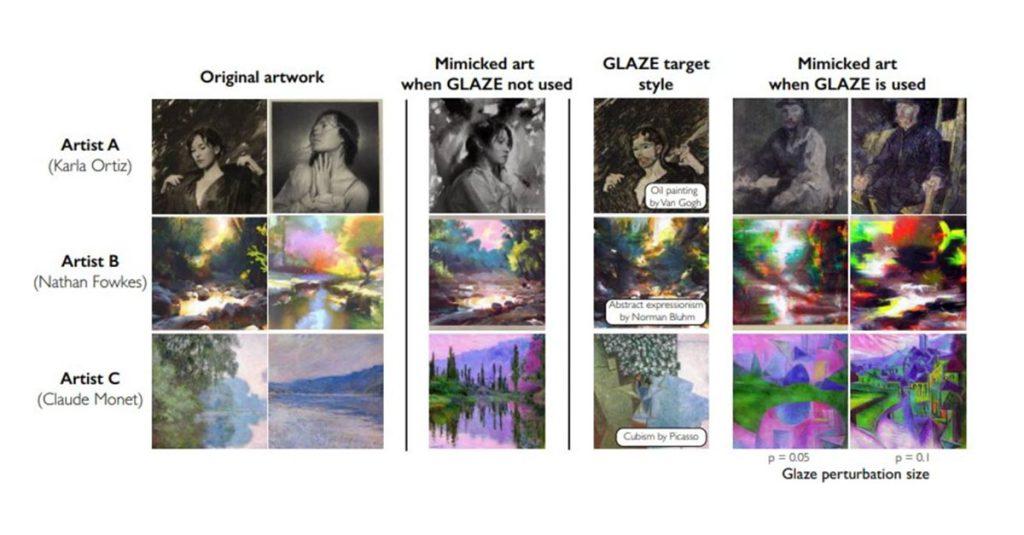

芝加哥大學的隨機分析和非線性動力學實驗室(SAND Lab)與專業藝術社群合作,打造機制來防堵AI模型的模仿,近日釋出了Glaze Beta2,只要使用者在上傳作品到網路上之前使用了Glaze,就能變更原始作品的元素,肉眼很難辨識這些變更,因此在網路上看起來與原作幾乎一模一樣。

SAND Lab將這些變更稱為「風格偽裝」(Style Cloak),可把在網路上流傳的Ortiz作品變成「偽裝藝術品」,以免遭到AI模型的剽竊,而且藝術家還可以指定所要偽裝的風格。

像是在與SAND Lab合作的逾1100名藝術家中,最有名的概念性藝術家Karla Ortiz,她指定將自己作品的風格偽裝成梵谷,即便作品在網路上看起來與原作一樣,卻會讓AI模型將其風格誤認為梵谷,而非Ortiz。可惜的是,SAND Lab表示,Glaze Beta2僅用於研究目的,他們並沒有打算商業化,發布的當下就能供外界免費下載及使用。

此外,Glaze Beta2目前最大的限制在於並非能夠永遠對抗AI的模仿,進展快速的AI技術很可能在未來就繞過Glaze,但SAND Lab團隊認為Glaze是必要的一步,可以在必要的法令出爐前先行保護藝術家。Glaze Beta2支援Windows 10/11 ,以及基於英特爾或M1/M2處理器的macOS。

瀏覽 1,507 次