打擊AI幻覺!OpenAI「過程監督」訓練正確推理

編譯/莊閔棻

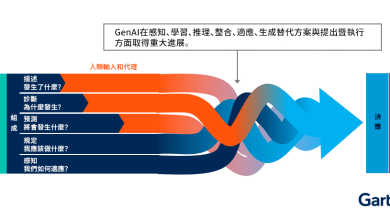

OpenAI宣布為了對抗人工智慧(AI)「幻覺」問題,他們採用了一種名為「過程監督」(process supervision)的新模型訓練方法。「過程監督」和「結果監督」(outcome supervision)不同,這種方法將讓AI更注重於「正確的推理過程」。

根據《CNBC》的報導,OpenAI 對抗捏造的潛在新策略是:訓練 AI 模型在推理答案時,在每個正確步驟上進行自我獎勵,以學習正確的推理過程,而不是只在得到正確的答案時給予獎勵。研究人員表示,這可能會訓練出更好的AI,因為該策略鼓勵模型按照更類似人類的「思考」的方式進行推理。

OpenAI 的數學論文生成器(mathgen)研究員 Karl Cobbe 就表示:「檢測和減輕一個模型的邏輯錯誤或幻覺,是建構通用人工智慧 (AGI)的關鍵步驟。」他指出,雖然這個「過程監督」方法不是OpenAI 發明的,但該公司正在推動其發展。 他說:「這項研究是為了解決幻覺問題,使模型在解決具有挑戰性的推理問題上,有更強的能力。」

OpenAI 研究人員表示:「即使是最先進的模型也容易生成假消息,因為它們在確定時,就會有捏造事實的傾向。而在需要多步驟推理的領域,這些幻覺問題又更嚴重,因為只要有一個邏輯錯誤,就可能會破壞整個解決方案。」Cobbe 表示,OpenAI 已經發布一個附帶的數據集,其中包含用於訓練研究論文中提到模型的 80萬個人工標記。

為了讓大型語言模型可以給出類似人類的回應,不論是OpenAI還是Google都一直在尋找解決方案。不過,因為數據被模型消化的方式不可預測,因此AI創造出非事實回應的「幻覺」問題到目前都還無法解決。在AI界,解決「幻覺」問題已經成為行業中的一大重點。

參考資料:CNBC

瀏覽 22,027 次