MIT新系統讓機器人不再靠感測器 「看」就能學會控制身體

記者李琦瑋/編譯

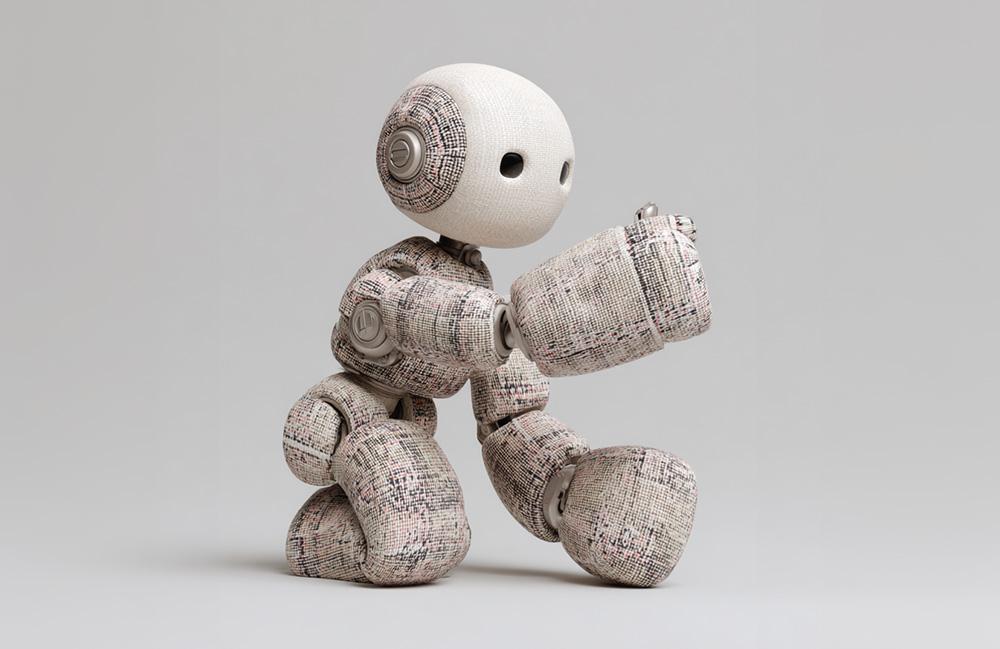

過去機器人要理解自身動作,往往需要複雜的感測器或精準的數學模型。然而,麻省理工學院電腦科學與人工智慧實驗室(MIT CSAIL)開發出全新視覺系統NJF,讓機器人只需透過單一攝影機觀察自身運動,就能學習如何控制身體,實現前所未有的「身體自我意識」。

這項研究顛覆了傳統機器人控制的思維。首席研究員、MIT CSAIL博士生Sizhe Lester Li表示,這項工作預示著機器人領域將從「程式設計」轉向「機器人教學」,如今,許多機器人任務需要大量的工程和編碼,「未來,我們設想只需向機器人展示要做什麼,讓它自主學習如何實現目標。」

延伸閱讀:特斯拉Optimus量產喊卡 設計調整揭人形機器人發展瓶頸

外媒《The Robot Report》指出,傳統機器人通常具備剛性結構且內建大量感測器,以便建立精確的數位孿生模型進行控制。然而,當機器人是柔軟、可變形或形狀不規則時,這些假設就不再適用。NJF的創新之處在於,它不強迫機器人符合預設模型,而是讓機器人透過觀察自身來學習其內部的運作模式。

這種建模與硬體設計的分離,將極大地拓展機器人設計空間。軟體機器人或仿生機器人設計師過去常需內嵌感測器或加固結構以實現建模,而NJF系統消除了這一限制。設計師可以更自由地探索非常規、不受限制的形態,無需擔心後續的建模或控制問題。

Li解釋道,「想想你是如何學習控制手指的:你扭動、你觀察、你適應。我們的系統就是這樣做的,它會嘗試隨機動作,並找出哪些控制指令會移動機器人的哪些部分。」

NJF系統已在多種類型的機器人上驗證其穩健性,包括氣壓式軟體機械手、剛性Allegro手、3D列印機械臂,甚至是沒有內嵌感測器的旋轉平台。在每個案例中,系統僅透過視覺和隨機運動,就學習了機器人的形狀以及對控制訊號的反應方式。

MIT CSAIL的研究人員表示,這種方法在實驗室之外具有廣闊的潛在應用。搭載NJF的機器人未來有望在農業領域實現厘米級的定位精度,在建築工地無需複雜的感測陣列即可操作,或在傳統方法失靈的動態環境中導航。

麻省理工學院助理教授Vincent Sitzmann說,當今的機器人技術,常因其高昂的感測器和複雜的程式設計而讓人覺得遙不可及,團隊開發NJF系統的目標,正是要降低這個門檻,讓機器人技術變得更經濟實惠、更具適應性,並能被更多人使用。

這份研究成果已於近期發表於《Nature》期刊,並獲得MIT研究支持基金、美國國家科學基金會及韓國光州科學技術院等機構資助。

資料來源:The Robot Report

瀏覽 149 次